私の環境でもImage to Videoができるってすごいかも

これもXのツイートで知りました

先日の記事で使ってみたDetail Daemonと同じく,このLTX Videoも西川和久さんのXのツイートを見て,ComfyUIを使ってローカルでImage to Videoができるなら試してみたいと思いました。

気になる点は私のNEXRGEARはGPUのメモリが8GBなので,きちんと動作するかは不安でした。

とりあえず環境を構築してみる

こちらやこちらのWebサイトの記事を参考にして,必要なファイルをダウンロードしたのですが,ファイル3つで29GB!くらいあるのには驚きました。

- ltx-video-2b-v0.9.safetensors(9.37GB)

- t5xxl_fp16.safetensors(9.79GB)

- model-00001-of-00002.safetensors(9.9GB)

それぞれのファイルを指示されている場所に置き,ComfyUIを起動してLTXVideoとVideoHelperSuiteという拡張機能をインストールしました。

さらにこちらのサイトからリンクをたどってImage to Videoのワークフローをダウンロードしました。

アイキャッチ用に生成した画像でI2V

テスト用ということで,以前Blogのアイキャッチ用に生成した画像を使い,プロンプトは適当に入力して動画を生成してみました。驚いたことにGPUのメモリが8GBのNEXTGEARで止まることなく動作し,数秒の動画ができあがりました。しかも結構速いです。

残念だったのは出来上がった映像が結構崩れてしまうことです。変更できるのかもしれませんが,ファイル形式がWebp形式というのも私的には微妙な感じです。

Civitaiで配布されているワークフローを使う

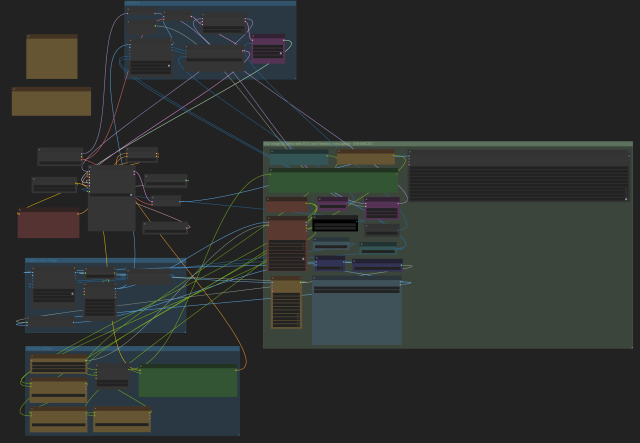

どうしたらいいか調べていると,最初に見つけた西川和久さんのXのツイートに別のワークフローへのリンクがありました。早速ダウンロードしてワークフローをDrag&Dropすると…とても複雑そうなワークフローでしかもインストールしていないカスタムノードがたくさんあって画面が真っ赤になっていました。

落ち着いてカスタムノードをインストールして,上記と同様にBlogのアイキャッチ用に生成した画像を使って動画を生成しました。

こちらのワークフローもGPUのメモリが8GBのNEXTGEARで止まることなく動作し,3秒の動画ができあがりました。最初の生成は時間がかかりますが,2本目以降は3秒の動画が2分弱で生成されることもありました。(サイズは768×384と小さいですが…)

出来上がった映像もそれほど崩れることなく見ることができます。これはなかなか面白いと感じました。

生成する動画の長さは,Video Lengthノードの数値で設定します。デフォルトの2倍の194に設定したところ7秒の動画が生成されました。生成時間は最短で3分くらいでした。当たり前ですが動画を長くすると生成に時間がかかりますが,もっと時間がかかると思っていたので意外でした。

人物の動きを指示したい

上記のワークフローはプロンプトをFlorence2というLLMで生成してくれるので画像を選ぶだけでいいのでお手軽です。画像からプロンプトを生成するので,imageとかphotoという単語が出てきますが,自動的にvideoに変換されるようです。

プロンプトを書き替えるときは,CLIP Text Encode (Positive Prompt)ノードを右クリックしてconvert Input to Widgetを選択すると入力欄が表示されるので,Show Textノードに表示されているプロンプトをコピーして書き換えるといいみたいです。

ローカル環境で動画が生成できる驚き

Hailuo AIを使ったとき,Stable Diffusionで生成した画像が動くという体験がとても驚きでした。今回はそれと同じようなことがローカル環境で実現できるということで,かなりワクワクしています。

しばらくの間は使い方を調べながら動画を生成する日々になりそうです。

この記事へのコメント

コメントはまだありません。

コメントを送る