色々試しています

SDXLで生成した画像をFLUX.1風にする

私がStable Diffusionでメインで使っているのはSDXL(Pony系モデル)です。こちらの記事でSDXLについて,RefinerにFLUX.1を使ったり,img2imgでFLUX.1を使ったり,後でFLUX.1を軽く被せるといい感じになる可能性があると紹介されていました。

記事の最初ではDetail Daemonが紹介されていました。顔や肌の質感がリアルになるので私も時々使いますが,使っていて感じることは私の環境ではアップスケールなしでも1枚1分以上と生成に時間がかかることです。

そこで,もう少しお手軽にFLUX.1風にしようと考えてimg2imgワークフローを作ることにしました。WebUIを使っていたときは結構使っていたimg2imgですが,ComfyUIでは使ったことがありませんでした。

img2imgのワークフローを作る

下記のWebサイトを参考にして,先日作成したFLUX.1用のワークフローを作り直すことにしました。

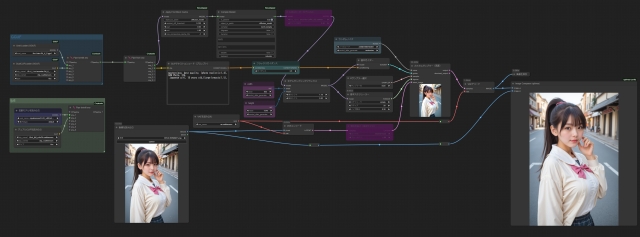

生成時間重視で等倍でimg2imgするワークフローです。元画像と比較ができるようにImage Compare(rgthree)ノードを使っています。この設定で1枚40秒台で生成できました。左(上)が元画像(SDXL)で右(下)がFLUX.1でimg2imgしたものです。

出来上がった画像を見るとSDXLの元画像の雰囲気を残しつつFLUX.1っぽくなっている気がします。生成する際のFLUX.1モデルを変えるとテイストが変わるのでいろいろ試すことができそうです。

Denoiseは0.3~0.6あたりがよさそう

Denoise(ノイズ除去)のパラメータで元画像にどのくらい忠実に生成するか調整ができるそうです。試しに0.3から0.9まで0.1刻みで同じ画像をimg2imgしたところ,0.6までは元画像に近い感じでしたが,0.7以上にすると元画像から離れていく感じでした。今回のサンプル画像は0.3で生成していますが低めがいい感じのようです。

この記事へのコメント

コメントはまだありません。

コメントを送る