インストールしたので色々使ってみました

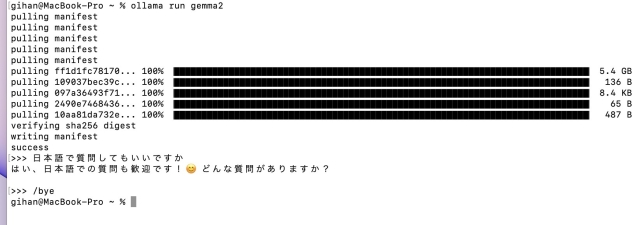

Gemma2と会話

最初にインストールしたLLMがGemma2です。Gemma2にしたのは比較検討して決めたわけではなく,LLMのインストール方法について参考にしたWebサイトでインストールしていたのがGemma2だったからです。

日本の選挙制度やおいしいカレーの作り方,StableDiffusionで美しい景色を出すプロンプトを教えてくださいと質問すると答えてくれました。また,英語と中国語が混在したWebページのテキストを日本語に翻訳してくださいとお願いしたら,Google翻訳と変わらないような日本語に訳してくれました。

返してくる日本語も不自然さがなく,普通に会話している感じです。NEXTGEARで使うとあまりタイムラグもなく返事がありましたが,以前StableDiffusionを使っていたノートPCだと動作がかなり遅くなりました。職場で使っているメインのPCにインストールすると便利かなと考えたのですが,上記のノートPCよりもスペックが低い(メモリ8GBでGPUもオンボード)のでやめました。

メモリが16GBのMacBook Pro(2016)ではどうかと考えインストールしてみましたが,動作速度は激遅で質問の答えが一文字表示されるのにかなりの待ち時間がありました。また,動作している間は他の作業はできない程集中している(?!)感じでした。

LLMを動作させるにはそれなりのスペックが必要なんだと感じ,MacBook Proからは速攻で削除しました。

Minicpm-v 8Bと会話

こちらは画像からプロンプトを生成するためにインストールしたLLMです。こちらも日本語で受け答えしてくれますが,Gemma2と比べると短めの回答であっさりした感じです。会話用として使うのであればGemma2の方がいいです。

会話するだけならUIはなくてもいいかも

今回はターミナルを使って会話をしました。本格的にLLMを使うのであれば,ブラウザで利用できるようにするOpenWebUIというソフトウェアがあるようですが,Dockerを使って構築するみたいなので私には難しいかなと考えています。

お試し程度に会話するだけならターミナルでも十分だと思います。他のLLMも使ってみたいのですが,ファイルサイズが結構大きいのでSSDの空き容量が心配になります。

この記事へのコメント

コメントはまだありません。

コメントを送る