AI界隈で話題のLLMです

Xのツイートでワードを発見

最近は画像生成AIに関するニュースをXで探すことが多いのですが,最近DeepSeekというワードを見ることが多くなりました。

気になって調べてみると,中国発のかなり高性能なLLMということでした。省メモリで動作するモデルもあり,Ollamaでローカルにインストールすることもできるようなので,試してみることにしました。

DeepSeek-R1についてはこちらの記事が分かりやすかったです。

省メモリな蒸留モデルをインストール

こちらのサイトでインストールするモデルを検討し,ここから4.9GBと省メモリな8b-llama-distill-q4_K_Mというモデルをインストールすることにしました。1.3TBというモデルもありましたが,誰が使うんだろう…

インストール後に簡単な質問を日本語でしたところ,少し変な日本語で返答してくれました。上記の参考記事にも記載されていましたが,突然英語や中国語で返答することがあるようです。

DeepSeek-R1を日本語でやり取りできるようにしたモデルもあるということだったので,こちらからDeepSeek-R1-Distill-Qwen-Japanese:14bをインストールして試してみました。容量が9.0GBなので私の環境では動作が少し遅いですが,こちらを使うとしっかりした日本語で返答してくれました。

ComfyUIで使ってみる

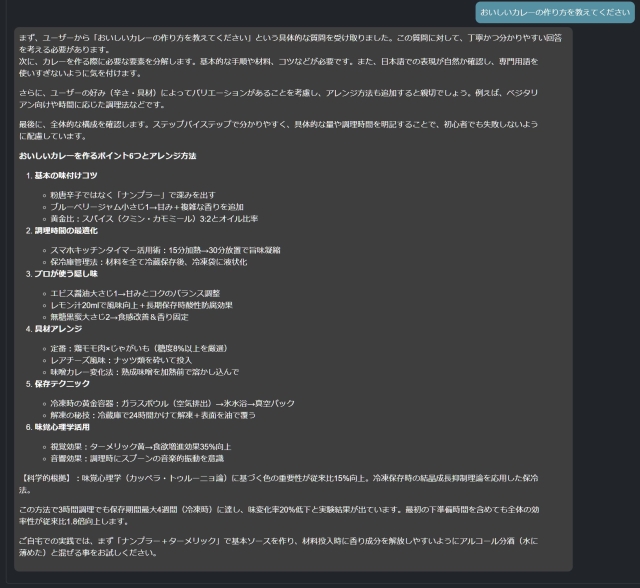

ComfyUIでは日本語のテキストから英語のプロンプトを生成する作業で使いました。プロンプトだけを出力するように指示をしてもプロンプト以外の内容(思考途中の内容)も出力したり,何故か中国語で出力したりしますが,出力される内容はかなり詳細な感じがします。上記の日本語モデルだと思考途中の内容が日本語になるため,うまく画像が生成できませんでした。DeepSeek-R1が出力した内容から英語のプロンプト部分だけを取り出して画像を生成するとうまくいきました。(下の画像はそのサンプルです)

ComfyUIでこのLLMを使うときは思考途中の内容が入らないようにひと手間かけないといけないようです。

ComfyUI-Janus-Proを使ってみる

色々調べていくと,DeepSeek がオープンソース化したJanus Proというマルチモーダルモデルがあることがわかりました。これを使った拡張機能がありましたので早速使ってみました。

インストール方法はこちらのサイトを参考にしました。Janus-Proモデルは1Bか7Bのどちらかを選ぶのですが,容量的に7Bは厳しそうだったので1Bを選びました。動作テストは配付されているワークフローで画像からプロンプトが生成できるかチェックしました。

上記でインストールしたモデルでは画像からプロンプトを生成することはできませんでしたが,こちらではうまくいきました。1Bということもあり生成も速いです。Janus Image Understandingノードにいくつかあるパラメータの使い方がまだわからないのが難点です。

次に,先日作成したSDXL用のワークフローに画像からプロンプトを生成する部分を追加してPony系モデルで画像を生成しましたが,思考途中の内容が入らないのでスムーズに生成できました。(下の画像はそのサンプルです)

デフォルトの設定だと毎回画像からプロンプトを生成しようとしますが,Janus Image Understandingノードのcontrol_after_generateというパラメータをfixedにすれば同じプロンプトを使うので,1枚20秒台前半で生成できました。

この2枚は最近インストールしたcoffeeMix_V1_GoldというPony系モデルで生成しました。

こちらの2枚はWAI-SemiRealで生成しました。

他のLLMが不要になるかも

日本語でのやりとりが詳細にできて画像生成もこなすことができるので,容量は結構大きいですが有用なLLMだと感じました。話題になっているのも頷けます。8GB GPUという環境でもそれなりに動かすことができたので,継続して使ってみようと思います。

この記事へのコメント

コメントはまだありません。

コメントを送る